Nesneler arasındaki uzaklıktan anladığımız şey genelde onlar arasındaki en kısa mesafedir. Örneğin bir doğrunun bir düzleme ya da iki düzlemin birbirine olan uzaklığını bulurken, bu iki kümenin noktaları arasındaki minimum uzaklığı elde etmeye çalışırız. Peki bu, iki nesnenin birbirine yakın olduğunu söylemek için yeterince iyi bir yöntem midir? Yani, bu nesneler birbirlerine oldukça yakın birer noktaya sahip olmalarına rağmen, diğer noktalar için bu durum geçerli olmayabilir mi?

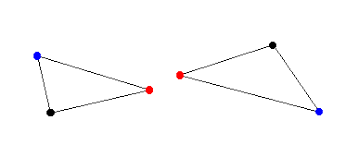

Örneğin yukarıdaki şekilde, iki üçgen arasındaki uzaklık değeri küçük olabilir, fakat şeklin geneline bakıldığında, bu değerin, mavi noktaların birbirine oldukça uzak olduğu gerçeğini yansıtmadığı açıktır. Şimdi yukarıdaki üçgenleri, aralarındaki uzaklık değişmeyecek şekilde, aşağıdaki gibi yeniden konumlandıralım.

Burada, konum değişmesine rağmen uzaklığın aynı kaldığını, dolayısıyla en kısa uzaklık kavramının nesnelerin konumundan tamamen bağımsız olduğu görebiliriz. Konu uygulamaya geldiğinde bu pek de istenilen bir özellik değildir. Neyse ki bu eksikliği ortadan kaldırmaya yardımcı olacak Hausdorff metriği vardır.

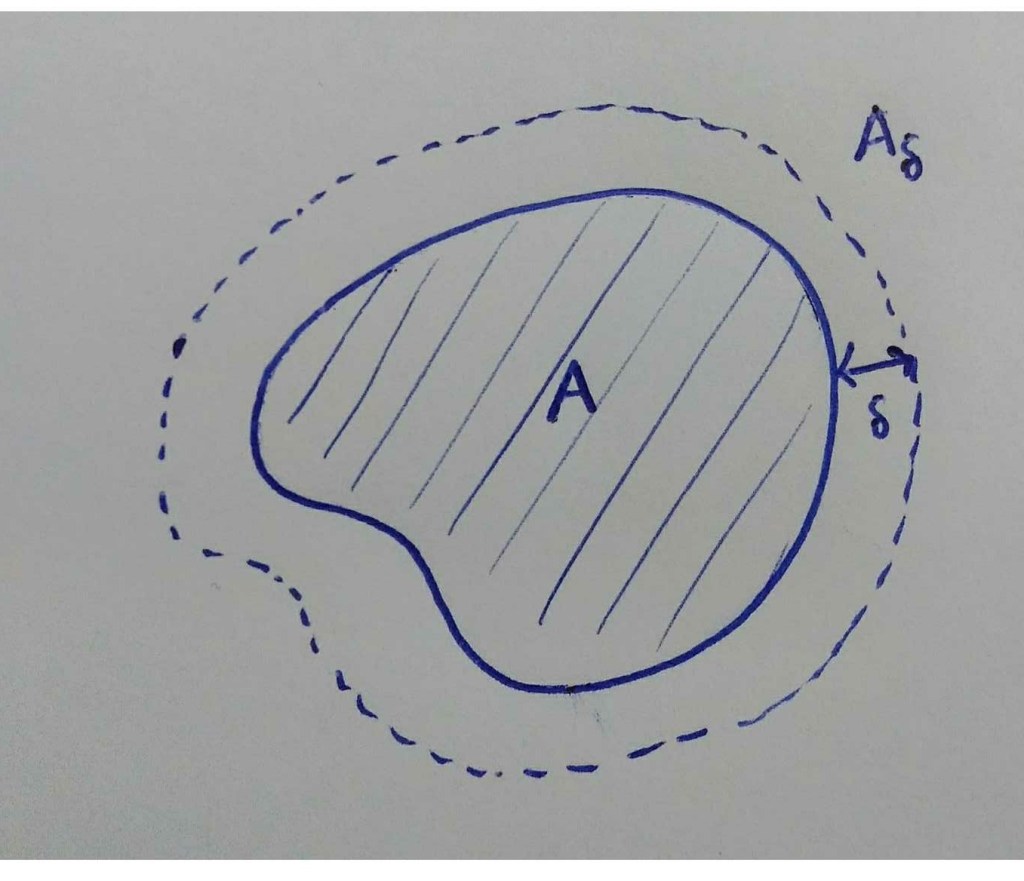

Hausdorff metriğin tanımını vermeden önce, bu metriğin neyi ölçtüğüne bir bakalım. İlk olarak çalışacağımız kümelerin kompakt olduğunu kabul edelim. için, bu kümeyi

kadar genişleterek elde edilen

kümesini tanımlayalım:

için

ve

olacak şekilde bir

elde etmeye, hatta bu özelliği sağlayan

‘ların en küçüğünü bulmaya çalışalım. (Kümeler kompakt olduğundan sınırlılar, dolayısıyla böyle bir

‘nın varlığından eminiz.) İşte elde ettiğimiz bu

bize A ve B arasındaki Hausdorff uzaklığı verecektir. Şimdi yine aynı örnek üzerinden, bu metriği nasıl tanımlayabileceğimize bakalım.

İlk olarak, ‘nın

‘yi kapsayan bir genişlemesini yani,

olacak şekilde bir

bulmaya çalışalım. Bunun için, önce

kümesinin her bir noktasının

kümesine olan (en kısa) uzaklığını, yani

‘yi buluruz.

‘nın

genişlemesinin

‘yi kapsaması için ise bu uzaklıkların en büyüğünü seçeriz. Bu durumda

olur.

Benzer şekilde, için

olduğunu da görebiliriz. Fakat amacımız

ve

kümeleri için ortak bir

elde etmek olduğundan

olarak seçeriz.

Hausdorff metriğinin en bilinen uygulamalarından biri, görüntü analizi, robotların görsel navigasyonu, bilgisayar destekli ameliyatlar gibi alanlarda kullanılan görüntü eşlemedir.

Yukarıdaki şekilde, solda verilen şablonun, sağdaki resimde olup olmadığını, varsa nerede olduğunu araştırırken Hausdorff metriği kullanılabilir. En iyi eşleşmeyi elde etmek için uzaklığın yeterince küçük olması gerekir.

Şimdi, asıl konumuza dönelim ve Hausdorff metriğin fraktal görüntü işleme alanında nasıl kullanıldığına bakalım.

Bir bilgisayarda görüntü depolarken karşılaşılan en temel sıkıntılardan biri depolama alanının kısıtlı olmasıdır. Görüntüyü depolarken, onu bir şekilde (sonlu bir) sıfırlar ve birler dizisine çevirmemiz gerekir. Bunu yapmak için görüntünün üzerine bir piksel ağı yerleştirdiğimizi ve bilgisayarın her pikselin değerini belleğine kaydettiğini düşünelim. Bir pikselin değeri, o noktadaki görüntünün siyah veya beyaz olmasına bağlı olarak 0 ya da 1 olsun. Bu yöntemde, görüntünün çözünürlüğü piksellerin büyüklüğüne bağlı olacaktır. Kullandığımız piksel sayısı depolama alanı ile sınırlıdır ve bu durum görüntünün netliğini ve ne kadar detaya sahip olup olmayacağını doğrudan etkiler. Bu sorunu çözmek fraktal sıkıştırma yöntemi kullanılabilir. Bunun için, işlemek istediğimiz görüntüye A diyelim ve ve

olacak şekilde bir

prosesi bulmaya çalışalım. Hausdorff metriği işte tam burada devreye giriyor, çünkü

olması

için,

ise

koşulunun sağlanması anlamına gelir. (Burada H Hausdorff metriği gösterir.) Bu yöntem sayesinde, tüm görüntüyü depolamak yerine ‘yi depolamak yeterli olacaktır.

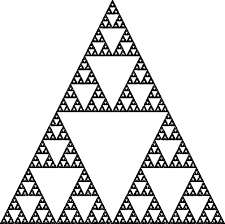

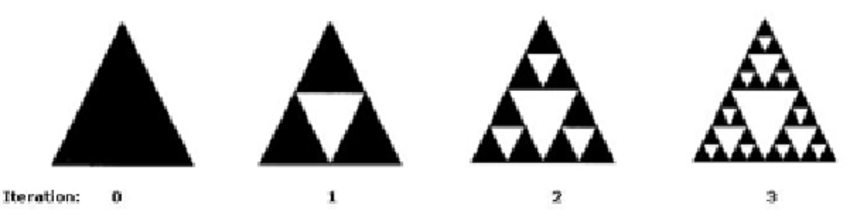

Yukarıda Sierpinski üçgeni ve onu elde etmek için kullanılan ilk üç iterasyonu görüyoruz. Bu üçgeni saklamak yerine, iterasyon kuralını saklamak tabii ki daha az yer kaplayacaktır.

Şimdi yukarıda anlatılanların matematiksel boyutuna bir bakalım.

bir tam metrik uzay olmak üzere,

kümesini tanımlayalım. Biliyoruz ki,

için

ile

kümesi arasındaki (en kısa) uzaklık

biçiminde tanımlıdır. Burada B kümesi kompakt ve metrik fonksiyonu sürekli olduğundan minimum değerin varlığından söz edebiliriz. Çünkü kompakt bir küme üzerinde sürekli bir fonksiyonun maksimum ve minimum değerlerini aldığını biliyoruz.

Şimdi de için

uzaklığını tanımlayalım. Dikkat edersek, h fonksiyonu

üzerinde bir metrik değildir, çünkü simetri özelliğini sağlamaz. Örneğin, d standart metrik olmak üzere,

tam metrik uzayında,

kompakt kümelerini düşünelim.

olur, dolayısıyla

‘dir.

Teorem: bir tam metrik uzay ve

,

olmak üzere

bir metrik uzaydır. (Bu metrik,

üzerinde Hausdorff metriğidir.)

Bir görüntüyü tam metrik uzayının kompakt bir alt kümesi olarak düşünebiliriz. Bu yaklaşımdan yola çıkarak, her bir görüntüyü

uzayının bir noktası olarak kabul edip, bu uzayı “fraktallar uzayı” olarak adlandıralım.

Teorem: bir tam metrik uzay olsun. Bu durumda,

bir tam metrik uzaydır. Ayrıca

,

‘de bir Cauchy dizisi olmak üzere,

biçiminde tanımlıdır.

Şimdi, ‘in bir tam metrik uzay olmasından ve Banach sabit nokta teoreminden yararlanarak yakınsak bir dizi elde etmeye çalışalım. Bunun için önce daraltma dönüşümünün tanımını ve sabit nokta teoreminin ifadesini verelim.

Tanım: bir metrik uzay,

bir dönüşüm ve

olsun. Eğer her

için

oluyorsa,

‘ye bir daraltma dönüşümü denir.

Teorem (Banach sabit nokta teoremi): bir tam metrik uzay ve

bir daraltma dönüşümü olsun. Bu durumda

‘nin tek bir sabit noktası vardır (Yani,

olacak şekilde tek bir

vardır). Ayrıca bu sabit nokta, her

için

biçiminde elde edilen

dizisinin limitidir, yani her

için

‘dir.

Demek ki, üzerinde bir

daraltma dönüşümü bulabilirsek, her

için, bu dönüşümün sabit noktasına yakınsayan bir

dizisi de elde etmiş oluruz. Bu dönüşümü bulurken, X üzerinde tanımlı bir daraltma dönüşümlerinden yararlanabiliriz.

Lemma: bir tam metrik uzay olsun.

1) sürekli bir fonksiyon ise, her

için

olur.

2) ,

faktörü ile bir daraltma dönüşümü ise,

,

üzerinde

faktörü ile bir daraltma dönüşümüdür, yani her

için

sağlanır.

Bu Lemma ile, X üzerinde tanımlı her daraltma dönüşümünün aynı zamanda üzerinde de bir daraltma dönüşümü olduğunu görmüş olduk. Şimdi

üzerinde daha kapsamlı bir daraltma dönüşümü elde edeceğiz.

Lemma: bir tam metrik uzay ve her

için

,

faktörüyle bir daraltma dönüşümü olsun. Bu durumda

,

,

faktörü ile bir daraltma dönüşümüdür.

Tanım: bir tam metrik uzay ve her

için

,

faktörüyle bir daraltma dönüşümü olmak üzere,

sistemine bir “Yinelemeli Fonksiyon Sistemi (Iterated Function System)” ya da kısaca bir IFS denir. Bu sistemin daraltma faktörü ise

‘dir.

Eğer ise, yukarıdaki Lemma gereğince

‘nin

üzerinde bir daraltma dönüşümü olduğunu söyleyebiliriz. O halde Banach Sabit Nokta Teoreminden,

‘nin tek bir

sabit noktası ve her

için,

olacak şekilde bir

dizisi vardır. Burada

kümesi, IFS’nin atraktörü olarak adlandırılır.

İşlemek istediğimiz bir görüntüyü, ‘nin kompakt bir altkümesi olarak düşünebileceğimizden bahsetmiştik. Amacımız,

‘de bir A görüntüsü verildiğinde, A’yı atraktör kabul eden bir IFS elde etmektir. Bu sayede, A görüntüsü yerine, içerisinde A’ya ulaşmak için gereken tüm bilgiler bulunan bir IFS’yi depolamış oluruz.

Şimdi bir kümesi alalım ve her

için

olacak şekilde bir

dönüşümü tanımlayalım. Bu durumda her

için

olduğundan

bir daraltma dönüşümüdür ve dönüşümün tanımdan

‘dir. O halde,

, atraktörü

olan bir IFS’dir. Tabii ki burada

‘yı depolamakla

‘yı depolamak aynı şey olduğundan,

yeterince işe yarar bir dönüşüm değildir. Ama en azından verilen her

görüntüsü için, atraktörü

olan (iyi ya da kötü) bir IFS bulunabileceğini görmüş olduk.

Son olarak aşağıdaki teorem ile, her görüntü için daha basit, yani bir anlamda depolanması daha kolay olacak bir IFS bulmanın mümkün olduğu görelim.

Teorem (Kolaj Teoremi): bir tam metrik uzay olsun.

ve

verilsin.

olacak şekilde, daraltma faktörüne sahip bir

seçelim. Bu durumda,

bu IFS’nin atraktörü olmak üzere,

eşitsizliği sağlanır. Denk olarak, her

için

‘dir.

Dolayısıyla, atraktörü, elimizdeki görüntüye yakın olan bir IFS bulmak için, yukarıdaki teoremde verilen (*) koşulunu sağlayan daraltma dönüşümleri bulmak gerekir. Bu teorem, belirli bir fraktal için bir IFS bulma problemini hemen çözmese de, probleme nasıl yaklaşılması gerektiği konusunda rehberlik eder.

Yukarıda kısaca anlattığımız, verilen bir görüntüyü, bir IFS ile temsil etme yöntemi “Fraktal Görüntü Sıkıştırma” olarak adlandırılır.

Son olarak, burada Kolaj Teoremi kullanılarak üretilmiş bir fraktal örneği bulabilirsiniz. Burada ise, Kolaj Teoreminin sahibi Michael Barnsley’in “Fractals Everywhere (Fraktallar Her Yerde)” adlı kitabında tanımladığı Barnsley Eğrelti otu isimli fraktalı elde etmek için kullanılan ve dört afin dönüşümden oluşan IFS’yi inceleyebilirsiniz.

Fraktallar her yerde olabilir, tamam, ama matematik de her yerdedir! 🙂

Kaynaklar

1)https://www.math.arizona.edu/~flaschka/Topmatter/527files/termpapers/mcmillen.pdf

2)https://www.youtube.com/watch?v=zGKfU91-hU0

3)http://cgm.cs.mcgill.ca/~godfried/teaching/cg-projects/98/normand/main.html